Deep Blue era um sistema de inteligência artificial extremamente evoluído cujo feito mais famoso é a sua vitória no xadrez, contra Garry Kasparov, o campeão humano por muitos considerado o melhor jogador de sempre. Tal proeza deu-se nos idos de 1997, após muitos anos de trabalho na e da máquina e, ainda mais, de trabalho do mestre. Kasparov, nessa altura com 34 anos, fora em 1985, com 22, o mais jovem campeão do mundo de xadrez e, com 13, havia vencido o campeonato de xadrez da União Soviética. Levava, pois, em 1997, cerca de 30 anos dedicados ao estudo e prática do xadrez de altíssimo nível. Trabalho esse, aquele a que se sujeitam os melhores, que recentemente ajudou a mostrar numa série de ficção de grande sucesso, “The Queen’s Gambit”, de que foi consultor. O interesse foi tanto que desencadeou o efeito Netflix logo a seguir à sua estreia, em outubro de 2020.

Segundo a Wikipédia - fenómeno extraordinário de democratização da informação e, em cada vez mais “entradas”, do conhecimento efetivo, na medida em que apresenta fontes vastas e credíveis ou, pelo menos, verificáveis e que se mantém firmemente acessível para que cada um que sabe alguma coisa sobre determinado assunto o possa disponibilizar ao mundo, de modo a que cada um que quer saber alguma coisa sobre determinado assunto o possa instantaneamente aprender – o Deep Blue “foi um supercomputador e um software criados pela IBM especialmente para jogar xadrez; com 256 co-processadores capazes de analisar aproximadamente 200 milhões de posições por segundo.”.

Ora, isto diz muitíssimo sobre a capacidade do humano Kasparov já que é perfeitamente razoável admitir que, tendo sido para Deep Blue, primeiro um adversário imbatível e, depois, batível com grande esforço, o seu cérebro biológico alimentado de estudo e experiência, conseguiria analisar perto de 200 milhões de posições por segundo. Acresce que Deep Blue era totalmente incapaz em tudo o resto e Kasparov demonstrava a capacidade usual de um humano para muitíssimas tarefas inerentes à sua condição e ao modo como vivia. Desde logo, sabia andar, coisa que fazia sem grande dificuldade desde tenra idade – talvez pouco antes de começar a jogar xadrez – habilidade que levou mais uns anos até ser conseguida por robots alimentados por inteligência artificial (Artificial Intelligence – AI).

Pode-se ver aqui exemplos da extraordinária evolução na locomoção e mobilidade dos robots, que começaram a ser desenvolvidos para, em cenários de guerra, irem onde os humanos não podiam, ou não deviam, devido à sua biológica fragilidade. Começaram por ser uma espécie de cães extremamente desengonçados, com a vantagem dos quatro apoios e, em duas “pernas” demoraram muito tempo a lidar com pequenos obstáculos e muito mais tempo ainda a subir escadas. A compra da Boston Dynamics pela Google, em 2013, foi um marco no desenvolvimento de robots hábeis em, digamos, movimentos livres. A robótica “clássica”, muito ligada à indústria, era essencialmente estática na sua estrutura e executava um ou mais movimentos iguais e repetidos com grande eficácia e precisão.

A evolução foi enorme e 2021 foi recebido por um vídeo que rapidamente se tornou viral, em que os robots da BD dançavam exuberantemente ao som de “Do you love me?” mostrando, entre outros, Spot, o tal dos quatro apoios, robot de algum modo parecido com um cão que pode ser comprado desde junho, por 74.500 dólares. O que mostra que qualquer um, desde que muito rico, pode comprar tecnologia de ponta.

A par da robótica, desenvolve-se a AI. Extraordinariamente.

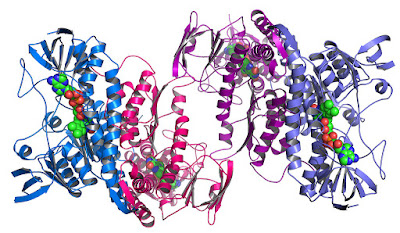

Deep Blue, programado por humanos, acumulava informação e processava-a a um ritmo muito rápido. A AI posterior começou a aprender sozinha, naquilo a que se chamou machine learning (ML) e, mais tarde com as redes neurais artificiais (ANN – Artificial Neural Nets), deep learning (DL). Essa aprendizagem começou por ser seguida de perto por cientistas humanos que tinham forte intervenção no seu desenvolvimento e que, progressivamente, se foram afastando do processo de programação. A ML, primeiro supervisionada, depois sem supervisão e, por fim, usando a aprendizagem por reforço, fez um caminho impressionante que surpreendeu os próprios cientistas, principalmente em áreas como o reconhecimento facial e a linguagem escrita e verbal.

Foi esse tipo de aprendizagem, que consiste em fixar objetivos, recompensando o sucesso e recusando o erro, deixando que o sistema de AI vá tentando e progredindo, que permitiu que o AlphaGo, em 2016, depois de aprender sozinho, em quatro horas, a jogar Go, o jogo mais complexo conhecido, tenha conseguido algum tempo depois derrotar o campeão do mundo, ao que se seguiram jogos com equipas mistas.

A Singularity Hub, agora, noticia um passo adiante.

Começa por explicar os básicos do DL: “Key to deep learning’s success is the fact the algorithms basically write themselves. Given some high-level programming and a dataset, they learn from experience. No engineer anticipates every possibility in code. The algorithms just figure it.”, isto é, os algoritmos evoluem sozinhos.

Depois, anuncia que “the DeepMind team

described a new deep reinforcement learning algorithm that was able to discover

its own value function—a critical programming rule in deep reinforcement

learning—from scratch.”, isto é, um algoritmo que cria algoritmos novos a partir

do nada.

O estudo está aqui e a notícia da SU aqui.

A DeepMind foi criada em 2010 e adquirida pela Google em 2014 e tem estado na liderança da investigação que, nesta área, é realmente muito cara.

Com algoritmos a criar algoritmos é difícil não perguntar “Então e nós, as pessoas, onde ficamos?”. Não, DeepMind, deixa lá, não te incomodes, é uma pergunta meramente retórica. De qualquer modo, a sério, preferimos não saber.

Sem comentários:

Enviar um comentário